NVIDIA H100 NVL: революционный подход к ускоренным вычислениям

Появление графических процессоров (GPU) произвело революцию в компьютерной индустрии, а NVIDIA лидировала. Последнее предложение компании, NVIDIA H100 НВЛ, является свидетельством ее стремления раздвинуть границы возможного в области ускоренных вычислений.

Содержание

- Беспрецедентная производительность и масштабируемость

- Вывод модели большого языка с наддувом NVIDIA H100 NVL

- Внедрение корпоративного ИИ NVIDIA H100 NVL

- Безопасное ускорение рабочих нагрузок

- Инференс глубокого обучения в реальном времени с помощью NVIDIA H100 NVL

- Эксафлопсные высокопроизводительные вычисления

- Ускоренная аналитика данных NVIDIA H100 NVL

- Готовое к использованию предприятие

- Встроенная функция конфиденциальных вычислений с NVIDIA H100 NVL

- Непревзойденная производительность для крупномасштабного ИИ и высокопроизводительных вычислений

- Технические характеристики изделия

- Заключительная мысль

- Видео Youtube о NVIDIA H100 NVL

- FAQ

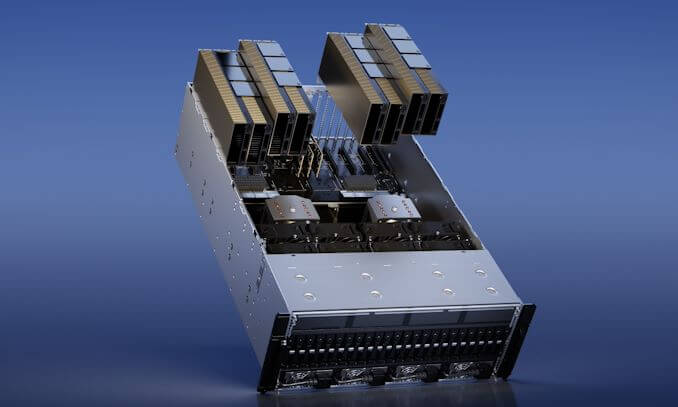

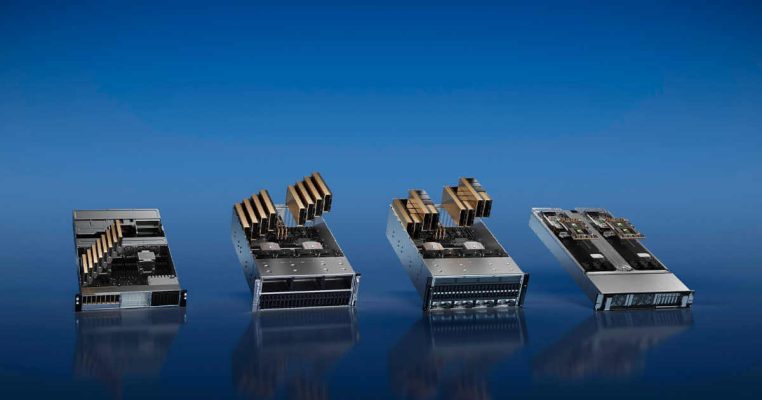

Беспрецедентная производительность и масштабируемость

Ассоциация NVIDIA H100 НВЛ это чудо современной технологии, предлагающее беспрецедентную производительность, масштабируемость и безопасность.

Система переключения NVIDIA NVLink позволяет легко управлять любой рабочей нагрузкой. Эта система позволяет соединить до 256 графических процессоров H100, что значительно увеличивает возможности ускоренных вычислений.

Кроме того, NVIDIA NVL имеет специализированный Transformer Engine. Кроме того, этот движок предназначен для обработки языковых моделей с триллионом параметров, что для большинства графических процессоров может оказаться сложной задачей.

Совместные технологические достижения NVIDIA H100 NVL могут ускорить модели больших языков (LLM) в 30 раз по сравнению с предыдущим поколением, что также делает его лидером в диалоговом ИИ.

Вывод модели большого языка с наддувом NVIDIA H100 NVL

Ассоциация NVIDIA H100 НВЛ речь идет не только о грубой силе; это также о изяществе. NVIDIA H100 с мостом NVLink обеспечивает оптимальную производительность для LLM со 175 миллиардами параметров за счет использования Transformer Engine, NVLink и памяти HBM188 объемом 3 ГБ.

Кроме того, эта комбинация обеспечивает простое масштабирование в любом центре обработки данных, выводя LLM в массовое русло.

Серверы с графическим процессором NVIDIA H100 NVL могут повысить производительность модели GPT-175B до 12 раз по сравнению с системами NVIDIA DGX A100.

Это повышение производительности достигается при сохранении низкой задержки в сценариях центра обработки данных с ограниченным энергопотреблением, что демонстрирует эффективность H100 NVL.

Внедрение корпоративного ИИ NVIDIA H100 NVL

Внедрение ИИ на предприятиях в настоящее время является распространенным явлением, и организациям нужна сквозная инфраструктура с поддержкой ИИ. NVIDIA H100 НВЛ Графические процессоры для основных серверов поставляются с пятилетней подпиской, включая корпоративную поддержку, на программный пакет NVIDIA AI Enterprise.

Этот пакет упрощает внедрение ИИ, предоставляя организациям доступ к платформам и технологиям ИИ, необходимым для создания процессов ИИ с ускорением H100, таких как чат-боты ИИ, механизмы рекомендаций, ИИ для зрения и многое другое.

Безопасное ускорение рабочих нагрузок

Ассоциация NVIDIA H100 НВЛ речь идет не только о производительности и масштабируемости; это также о безопасности. Графический процессор предназначен для безопасного ускорения рабочих нагрузок, начиная от корпоративных и заканчивая эксафлопсными.

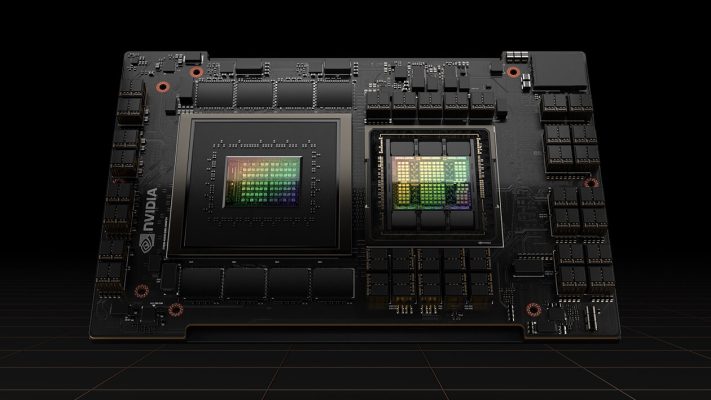

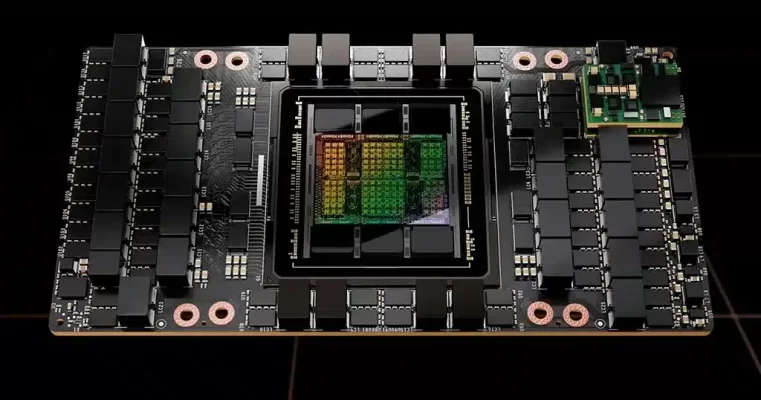

Он имеет тензорные ядра четвертого поколения и Transformer Engine с точностью FP8, что позволяет проводить обучение моделей GPT-4 (3B) в 175 раза быстрее, чем предыдущая итерация.

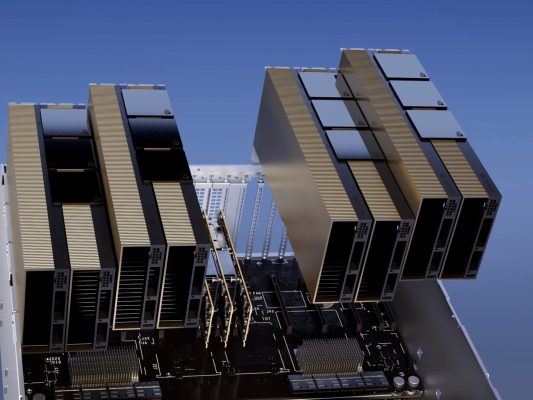

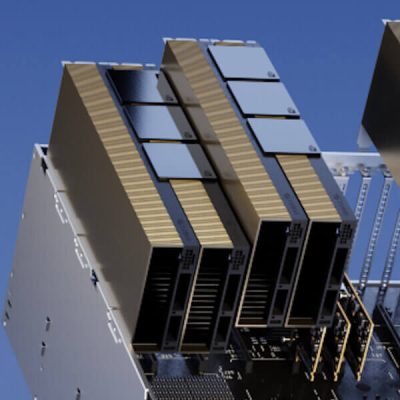

Комбинация NVLink четвертого поколения, обеспечивающая скорость соединения GPU-to-GPU со скоростью 900 ГБ/с; Сеть NDR Quantum-2 InfiniBand, которая ускоряет обмен данными между каждым графическим процессором между узлами; PCIe 5-го поколения; а программное обеспечение NVIDIA Magnum IO обеспечивает эффективное масштабирование от небольших корпоративных систем до массивных унифицированных кластеров графических процессоров.

Инференс глубокого обучения в реальном времени с помощью NVIDIA H100 NVL

Ассоциация NVIDIA H100 НВЛ расширяет лидерство NVIDIA на рынке логических выводов с помощью нескольких улучшений, которые ускоряют логические выводы до 30 раз и обеспечивают минимальную задержку.

Тензорные ядра четвертого поколения ускоряют все точности, включая FP64, TF32, FP32, FP16, INT8, а теперь и FP8, уменьшая использование памяти и повышая производительность при сохранении точности LLM.

Эксафлопсные высокопроизводительные вычисления

Ассоциация NVIDIA H100 НВЛ в три раза увеличивает количество операций с плавающей запятой в секунду (FLOPS) тензорных ядер двойной точности, обеспечивая 60 терафлопс вычислений FP64 для высокопроизводительных вычислений. Приложения для высокопроизводительных вычислений с искусственным интеллектом также могут использовать точность H100 TF32 для достижения производительности в один петафлопс для операций умножения матриц с одинарной точностью, не требуя модификации кода.

Ускоренная аналитика данных NVIDIA H100 NVL

Ассоциация NVIDIA H100 НВЛ обеспечивает вычислительную мощность, а также пропускную способность памяти 3 терабайта в секунду (ТБ/с) на каждый графический процессор и масштабируемость с помощью NVLink и NVSwitch — для высокопроизводительного анализа данных и масштабирования для поддержки больших наборов данных.

Архитектура центра обработки данных NVIDIA в сочетании с NVIDIA Quantum-2 InfiniBand, ПО Magnum IO, Spark 3.0 с ускорением на GPU и NVIDIA RAPIDS обладает уникальными возможностями для ускорения этих масштабных рабочих нагрузок с непревзойденным уровнем производительности и эффективности.

Готовое к использованию предприятие

NVIDIA H100 NVL использует технологию Multi-Instance GPU (MIG) второго поколения, которая максимально увеличивает использование GPU, безопасно разделяя его на семь отдельных экземпляров.

Кроме того, с поддержкой конфиденциальных вычислений, NVIDIA H100 НВЛ обеспечивает безопасное сквозное многопользовательское использование, что делает его идеальным для сред поставщиков облачных услуг (CSP).

Встроенная функция конфиденциальных вычислений с NVIDIA H100 NVL

NVIDIA Confidential Computing — это встроенная функция безопасности архитектуры Hopper, которая делает NVIDIA H100 НВЛ первый в мире ускоритель с возможностями конфиденциальных вычислений.

Пользователи могут поддерживать безопасность и целостность своих данных и приложений, получая при этом непревзойденное ускорение графических процессоров H100.

Непревзойденная производительность для крупномасштабного ИИ и высокопроизводительных вычислений

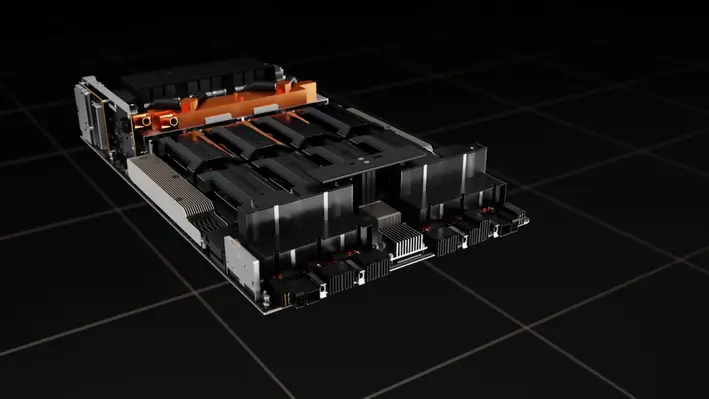

Архитектура ЦП+ГП NVIDIA Grace Hopper, специально созданная для ускоренных вычислений в терабайтном масштабе и обеспечивающая 10-кратное повышение производительности на больших моделях ИИ и высокопроизводительных вычислений, также будет работать на графическом процессоре Hopper Tensor Core.

ЦП NVIDIA Grace использует гибкость архитектуры Arm для создания архитектуры ЦП и сервера, разработанной снизу вверх для ускорения вычислений.

Графический процессор Hopper подключен к центральному процессору Grace через сверхбыстрый межчиповый интерфейс NVIDIA, который обеспечивает пропускную способность 900 ГБ/с, что в 7 раз быстрее, чем PCIe Gen5.

Технические характеристики изделия

Вот сравнительная таблица Н100 НВЛ в разных форм-факторах:

| Форм-фактор | FP64 | Тензорное ядро FP64 | FP32 | Тензорное ядро TF32 | Тензорное ядро BFLOAT16 | Память графического процессора | Пропускная способность памяти графического процессора |

| Н100 СХМ | 34 терафлопс | 67 терафлопс | 67 терафлопс | 989 терафлопс | 1,979 терафлопс | 80GB | 3.35 ТБ / с |

| H100 PCIe | 26 терафлопс | 51 терафлопс | 51 терафлопс | 756 терафлопс | 1,513 терафлопс | 80GB | 2 ТБ / с |

| Н100 НВЛ | 68 терафлопс | 134 терафлопс | 134 терафлопс | 1,979 терафлопс | 3,958 терафлопс | 188GB | 7.8 ТБ / с |

Заключительная мысль

Ассоциация NVIDIA H100 НВЛ меняет правила игры в мире ускоренных вычислений. Его производительность, масштабируемость и безопасность изменят ИИ, высокопроизводительные вычисления, а также аналитику данных. Вычисления на базе H100 NVL — это будущее.

H100 NVL демонстрирует стремление NVIDIA к ускорению вычислений за счет расширения возможностей логического вывода модели и обеспечения секретных вычислений. H100 NVL определит будущее вычислений.

Видео Youtube о NVIDIA H100 NVL

Вам также может понравиться

Преимущества облачных вычислений для малого бизнеса

10 лучших компьютерных игр всех времен

FAQ

Tensor Core GPU H100 NVL обеспечивает непревзойденную производительность, масштабируемость и безопасность. Система коммутаторов NVIDIA NVLink подключает до 256 графических процессоров H100, а Transformer Engine обрабатывает языковые модели с триллионами параметров, а встроенные секретные вычисления обеспечивают ускорение рабочих нагрузок от предприятия до экзафлопсного.

H100 NVL с мостом NVLink оптимизирует LLM до 175 миллиардов параметров, используя Transformer Engine, NVLink и память HBM188 объемом 3 ГБ. Кроме того, эта комбинация делает LLM популярными, обеспечивая масштабируемость всего центра обработки данных.

Высокопроизводительное ПО NVIDIA AI Enterprise упрощает внедрение ИИ. Графические процессоры H100 NVL для основных серверов поставляются с пятилетней подпиской, а также корпоративной поддержкой. Этот пакет предоставляет организациям платформы и инструменты для процессов искусственного интеллекта с ускорением H100.

Технология Multi-Instance GPU (MIG) второго поколения H100 NVL надежно разделяет каждый GPU на семь экземпляров для максимального использования GPU. Кроме того, это обеспечивает сквозное многопользовательское использование, что делает его идеальным для ситуаций с поставщиками облачных услуг (CSP).

Архитектура ЦП+ГП NVIDIA Grace Hopper ускоряет ИИ для больших моделей и HPC в 10 раз. Архитектура Arm позволяет ЦП NVIDIA Grace создавать архитектуру ЦП и сервера, оптимизированную для ускоренных вычислений. Сверхбыстрое межчиповое соединение NVIDIA соединяет ЦП Grace и ГП Hopper, обеспечивая пропускную способность 900 ГБ/с, что в 7 раз быстрее, чем PCIe Gen5.