NVIDIA H100 NVL: un cambio de juego en computación acelerada

La introducción de las unidades de procesamiento de gráficos (GPU) revolucionó la industria informática, con NVIDIA a la cabeza. La última oferta de la empresa, la NVIDIA H100 NVL, es un testimonio de su compromiso de ampliar los límites de lo que es posible en la computación acelerada.

Tabla de contenidos.

- Rendimiento y escalabilidad sin precedentes

- Inferencia de modelo de lenguaje grande sobrealimentado NVIDIA H100 NVL

- Adopción de IA empresarial de NVIDIA H100 NVL

- Cargas de trabajo aceleradas de forma segura

- Inferencia de aprendizaje profundo en tiempo real de NVIDIA H100 NVL

- Informática de alto rendimiento a exaescala

- Análisis de datos acelerado NVIDIA H100 NVL

- Utilización lista para la empresa

- Informática confidencial integrada con NVIDIA H100 NVL

- Rendimiento incomparable para IA y HPC a gran escala

- Especificaciones del producto

- Pensamiento final

- Vídeo de Youtube sobre NVIDIA H100 NVL

- Preguntas Frecuentes

Rendimiento y escalabilidad sin precedentes

El NVIDIA H100 NVL es una maravilla de la tecnología moderna que ofrece un rendimiento, escalabilidad y seguridad sin precedentes.

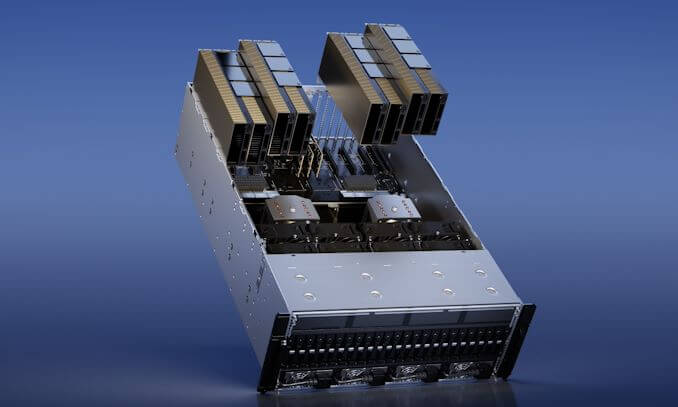

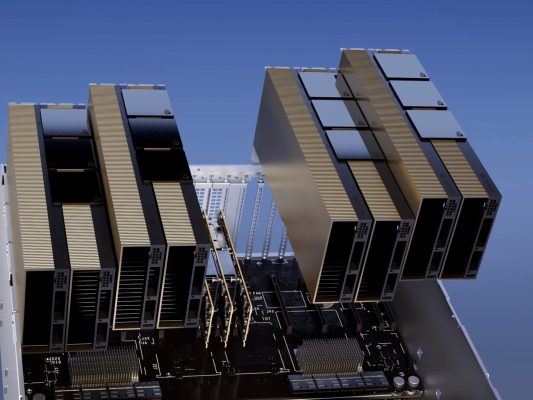

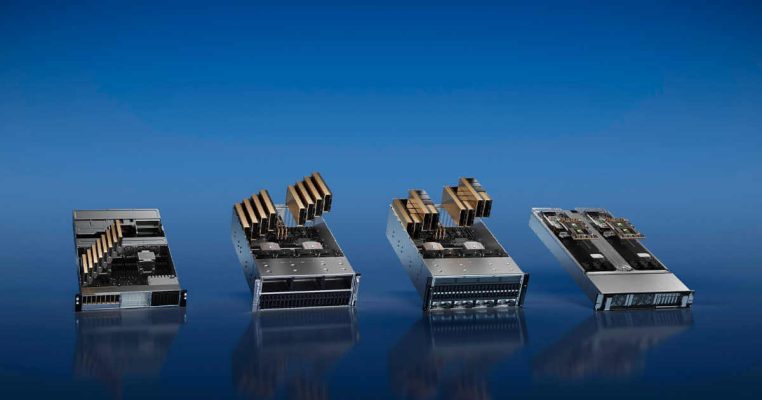

El sistema de conmutador NVIDIA NVLink le permite administrar cualquier carga de trabajo con facilidad. Este sistema permite la interconexión de hasta 256 GPU H100, lo que se traduce en un aumento significativo de las capacidades informáticas aceleradas.

Además, NVIDIA NVL tiene un Transformer Engine especializado. Además, este motor está diseñado para manejar modelos de lenguaje de billones de parámetros, una tarea que la mayoría de las GPU encontrarían difícil.

Los avances tecnológicos combinados de NVIDIA H100 NVL pueden acelerar los modelos de lenguajes extensos (LLM) 30 veces más que la generación anterior, lo que también lo convierte en líder en inteligencia artificial conversacional.

Inferencia de modelo de lenguaje grande sobrealimentado NVIDIA H100 NVL

El NVIDIA H100 NVL no se trata solo de potencia bruta; también se trata de delicadeza. NVIDIA H100 con puente NVLink proporciona un rendimiento óptimo para LLM con hasta 175 188 millones de parámetros mediante el uso de Transformer Engine, NVLink y memoria HBM3 de XNUMX GB.

Además, esta combinación permite una escalabilidad simple en cualquier centro de datos, lo que lleva a los LLM a la corriente principal.

Los servidores equipados con GPU NVIDIA H100 NVL pueden aumentar el rendimiento del modelo GPT-175B hasta 12 veces más que los sistemas NVIDIA DGX A100.

Este impulso en el rendimiento se logra manteniendo una baja latencia en escenarios de centros de datos con limitaciones de energía, lo que demuestra la eficiencia del H100 NVL.

Adopción de IA empresarial de NVIDIA H100 NVL

La adopción de IA en las empresas ahora es generalizada y las organizaciones necesitan una infraestructura lista para IA de extremo a extremo. El NVIDIA H100 NVL Las GPU para servidores convencionales vienen con una suscripción de cinco años, que incluye soporte empresarial, al paquete de software NVIDIA AI Enterprise.

Este paquete agiliza la adopción de IA al garantizar que las organizaciones tengan acceso a los marcos y tecnologías de IA necesarios para construir procesos de IA acelerados por H100, como chatbots de IA, motores de recomendación, IA de visión y más.

Cargas de trabajo aceleradas de forma segura

El NVIDIA H100 NVL no se trata solo de rendimiento y escalabilidad; también se trata de seguridad. La GPU está diseñada para acelerar de manera segura las cargas de trabajo que van desde las corporativas hasta las de gran escala.

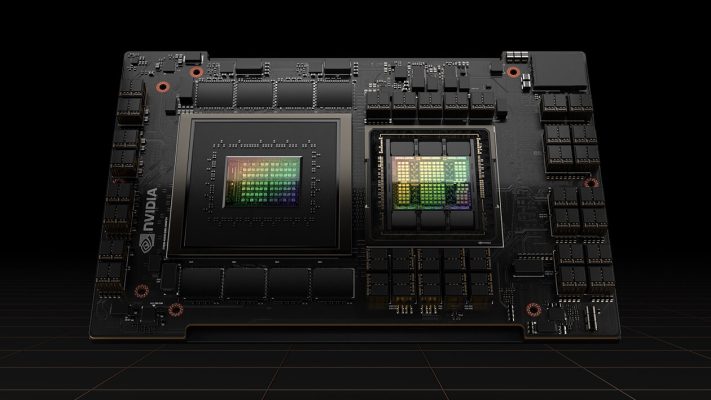

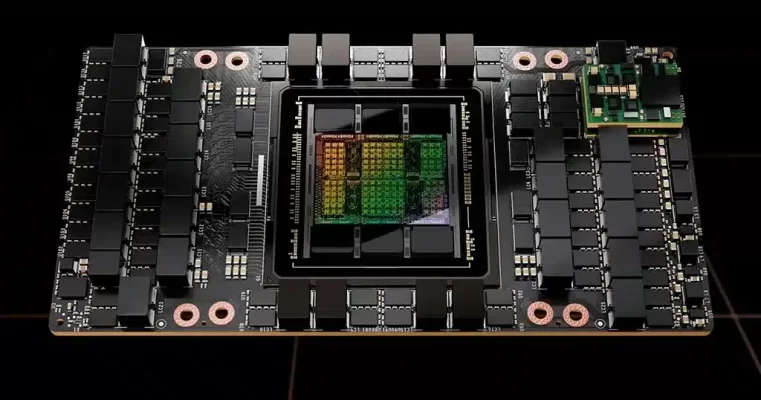

Tiene núcleos tensoriales de cuarta generación y un motor de transformador con precisión FP8, lo que permite un entrenamiento hasta 4 veces más rápido para los modelos GPT-3 (175B) que la iteración anterior.

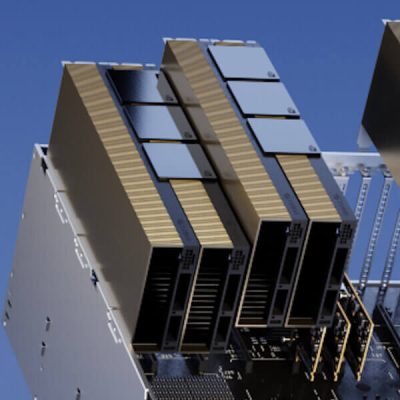

La combinación de NVLink de cuarta generación, que proporciona 900 GB/s de interconexión de GPU a GPU; Red NDR Quantum-2 InfiniBand, que acelera la comunicación de cada GPU entre nodos; PCIe Gen5; y el software NVIDIA Magnum IO permite escalar eficientemente desde sistemas de pequeñas empresas hasta clústeres de GPU unificados y masivos.

Inferencia de aprendizaje profundo en tiempo real de NVIDIA H100 NVL

El NVIDIA H100 NVL amplía el liderazgo de inferencia líder en el mercado de NVIDIA con varios avances que aceleran la inferencia hasta 30 veces y ofrecen la latencia más baja.

Los Tensor Cores de cuarta generación aceleran todas las precisiones, incluidas FP64, TF32, FP32, FP16, INT8 y ahora FP8, lo que reduce el uso de memoria y aumenta el rendimiento al tiempo que conserva la precisión LLM.

Informática de alto rendimiento a exaescala

El NVIDIA H100 NVL triplica las operaciones de coma flotante por segundo (FLOPS) de los Tensor Cores de doble precisión, lo que proporciona 60 teraflops de computación FP64 para HPC. Las aplicaciones de HPC con infusión de IA también pueden utilizar la precisión TF100 del H32 para alcanzar un petaflop de rendimiento para operaciones de multiplicación de matriz de precisión simple sin necesidad de modificar el código.

Análisis de datos acelerado NVIDIA H100 NVL

El NVIDIA H100 NVL ofrece la potencia informática, junto con 3 terabytes por segundo (TB/s) de ancho de banda de memoria por GPU y escalabilidad con NVLink y NVSwitch, para abordar el análisis de datos con alto rendimiento y escala para admitir conjuntos de datos masivos.

La arquitectura del centro de datos NVIDIA, cuando se combina con NVIDIA Quantum-2 InfiniBand, el software Magnum IO, Spark 3.0 acelerado por GPU y NVIDIA RAPIDS, está equipada de manera única para acelerar estas cargas de trabajo masivas con niveles insuperables de rendimiento y eficiencia.

Utilización lista para la empresa

NVIDIA H100 NVL incorpora tecnología GPU de instancias múltiples (MIG) de segunda generación, que maximiza la utilización de la GPU dividiéndola de forma segura en hasta siete instancias distintas.

También con soporte informático confidencial, el NVIDIA H100 NVL permite un uso seguro, de extremo a extremo y de múltiples inquilinos, lo que lo hace ideal para entornos de proveedores de servicios en la nube (CSP).

Informática confidencial integrada con NVIDIA H100 NVL

NVIDIA Confidential Computing es una característica de seguridad integrada de la arquitectura Hopper que hace que el NVIDIA H100 NVL el primer acelerador del mundo con capacidades informáticas confidenciales.

Los usuarios pueden mantener la seguridad e integridad de sus datos y aplicaciones mientras se benefician de la aceleración sin igual de las GPU H100.

Rendimiento incomparable para IA y HPC a gran escala

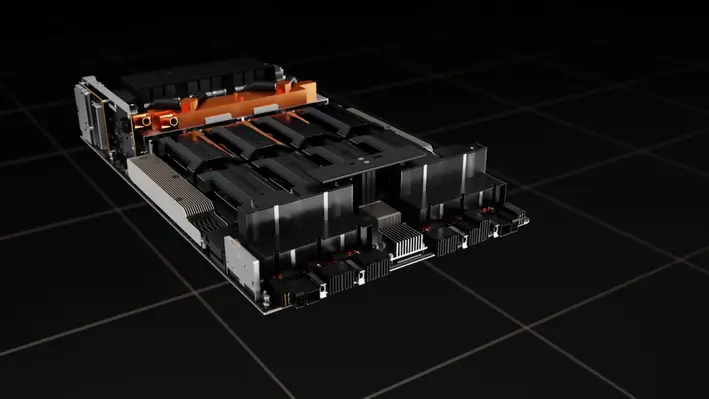

La arquitectura NVIDIA Grace Hopper CPU+GPU, diseñada específicamente para computación acelerada a escala de terabytes y que permite un rendimiento 10 veces mayor en modelos grandes de IA y HPC, también contará con la tecnología de Hopper Tensor Core GPU.

La CPU NVIDIA Grace aprovecha la flexibilidad de la arquitectura Arm para producir una arquitectura de servidor y CPU diseñada de abajo hacia arriba para un cómputo acelerado.

La GPU Hopper está conectada a la CPU Grace a través de la interfaz de chip a chip ultrarrápida de NVIDIA, que proporciona 900 GB/s de ancho de banda, que es 7 veces más rápido que PCIe Gen5.

Especificaciones del producto

Aquí hay una tabla de comparación de los H100 NVL en diferentes factores de forma:

| Factor de forma | FP64 | Núcleo tensor FP64 | FP32 | Núcleo tensor TF32 | Núcleo tensor BFLOAT16 | Memoria de la GPU | Ancho de banda de memoria GPU |

| H100 SXM | 34 teraFLOPS | 67 teraFLOPS | 67 teraFLOPS | 989 teraFLOPS | 1,979 teraFLOPS | 80GB | 3.35 TB / s |

| PCIe H100 | 26 teraFLOPS | 51 teraFLOPS | 51 teraFLOPS | 756 teraFLOPS | 1,513 teraFLOPS | 80GB | 2 TB / s |

| H100 NVL | 68 teraFLOPS | 134 teraFLOPS | 134 teraFLOPS | 1,979 teraFLOPS | 3,958 teraFLOPS | 188GB | 7.8 TB / s |

Pensamiento final

El NVIDIA H100 NVL es un cambio de juego en el mundo de la computación acelerada. Su rendimiento, escalabilidad y seguridad transformarán la IA, la HPC y también el análisis de datos. La informática con H100 NVL es el futuro.

El H100 NVL muestra la dedicación de NVIDIA a la computación acelerada al potenciar la inferencia de modelos de lenguaje grande y también al proporcionar computación secreta. El H100 NVL dará forma al futuro de la informática.

Vídeo de Youtube sobre NVIDIA H100 NVL

También te puede interesar

Los beneficios de la computación en la nube para las pequeñas empresas

Los 10 mejores juegos de computadora de todos los tiempos

Preguntas Frecuentes

Tensor Core GPU H100 NVL ofrece rendimiento, escalabilidad y seguridad inigualables. El sistema NVIDIA NVLink Switch conecta hasta 256 GPU H100, también el motor Transformer maneja modelos de lenguaje de billones de parámetros y la computación secreta está integrada. Asegura la aceleración de la carga de trabajo de la empresa a la exaescala.

El H100 NVL con puente NVLink optimiza LLM hasta 175 mil millones de parámetros usando su Transformer Engine, NVLink y 188 GB de memoria HBM3. Además, esta combinación hace que los LLM se generalicen al permitir la escalabilidad en todo el centro de datos.

El software NVIDIA AI Enterprise de alto rendimiento simplifica la adopción de IA. Las GPU H100 NVL para servidores principales vienen con una suscripción de cinco años y también con soporte empresarial. Este paquete proporciona herramientas y marcos de procesos de IA acelerados por H100 para las organizaciones.

La tecnología de GPU de instancias múltiples (MIG) de H100 NVL de segunda generación divide de forma segura cada GPU en siete instancias para maximizar la utilización de GPU. Además, esto asegura el uso de múltiples inquilinos de un extremo a otro, lo que lo hace perfecto para situaciones de proveedores de servicios en la nube (CSP).

La arquitectura NVIDIA Grace Hopper CPU+GPU acelera la IA de modelos grandes y HPC 10X. La arquitectura Arm permite que la CPU NVIDIA Grace construya una arquitectura de servidor y CPU optimizada para computación acelerada. La conexión chip a chip ultrarrápida de NVIDIA conecta la CPU Grace y la GPU Hopper, brindando 900 GB/s de ancho de banda, 7 veces más rápido que PCIe Gen5.