NVIDIA H100 NVL: ตัวเปลี่ยนเกมในการประมวลผลแบบเร่งความเร็ว

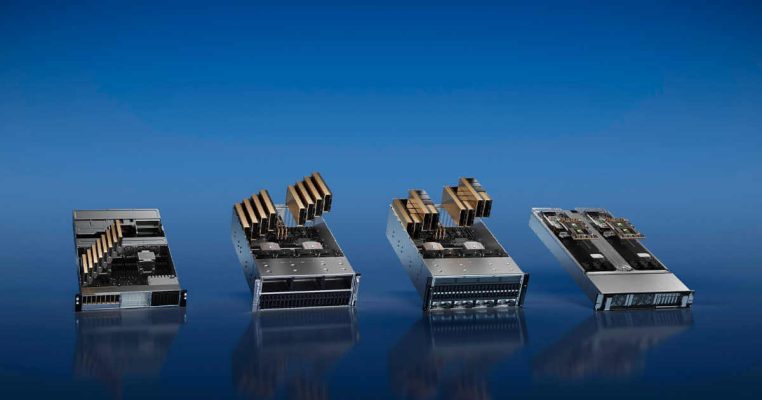

การเปิดตัวหน่วยประมวลผลกราฟิก (GPU) ปฏิวัติอุตสาหกรรมคอมพิวเตอร์โดยมี NVIDIA เป็นผู้นำในการขับเคลื่อน ข้อเสนอล่าสุดของบริษัทคือ NVIDIA H100 NVLเป็นข้อพิสูจน์ถึงความมุ่งมั่นในการผลักดันขอบเขตของสิ่งที่เป็นไปได้ในการคำนวณแบบเร่งความเร็ว

สารบัญ

- ประสิทธิภาพและความสามารถในการปรับขนาดอย่างที่ไม่เคยมีมาก่อน

- การอนุมานโมเดลภาษาขนาดใหญ่ของ NVIDIA H100 NVL

- การนำ AI ระดับองค์กรมาใช้ NVIDIA H100 NVL

- เร่งความเร็วของปริมาณงานอย่างปลอดภัย

- การอนุมานการเรียนรู้เชิงลึกตามเวลาจริงของ NVIDIA H100 NVL

- คอมพิวเตอร์ประสิทธิภาพสูง Exascale

- การวิเคราะห์ข้อมูลแบบเร่งความเร็วของ NVIDIA H100 NVL

- การใช้งานระดับองค์กร

- ระบบคอมพิวเตอร์ที่เป็นความลับในตัวด้วย NVIDIA H100 NVL

- ประสิทธิภาพที่เหนือชั้นสำหรับ AI และ HPC ขนาดใหญ่

- ข้อมูลจำเพาะของผลิตภัณฑ์

- ความคิดสุดท้าย

- วิดีโอ Youtube เกี่ยวกับ NVIDIA H100 NVL

- คำถามที่พบบ่อย

ประสิทธิภาพและความสามารถในการปรับขนาดอย่างที่ไม่เคยมีมาก่อน

พื้นที่ NVIDIA H100 NVL คือความมหัศจรรย์ของเทคโนโลยีสมัยใหม่ที่มอบประสิทธิภาพที่ไม่เคยมีมาก่อน ความสามารถในการปรับขนาด และความปลอดภัย

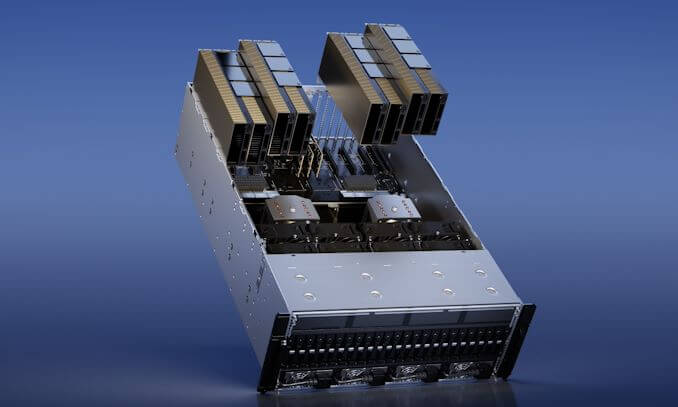

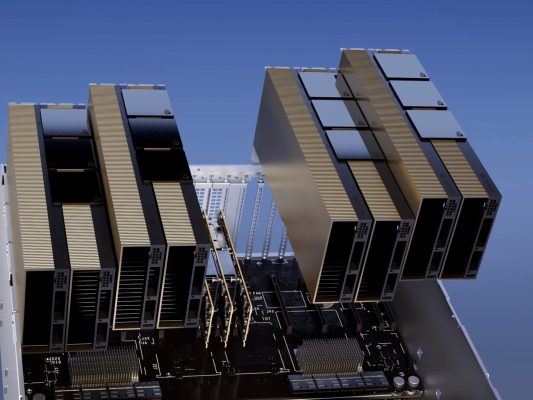

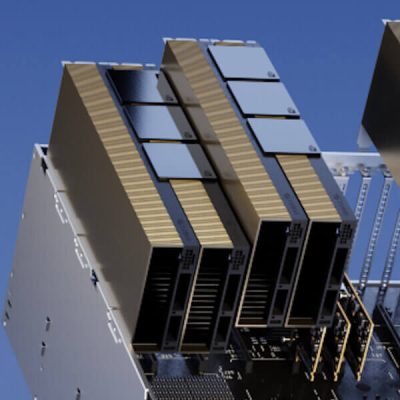

ระบบสวิตช์ NVIDIA NVLink ช่วยให้สามารถจัดการปริมาณงานได้อย่างง่ายดาย ระบบนี้ช่วยให้สามารถเชื่อมต่อได้ถึง 256 H100 GPU ส่งผลให้ความสามารถในการประมวลผลเพิ่มขึ้นอย่างมาก

นอกจากนี้ NVIDIA NVL ยังมี Transformer Engine พิเศษอีกด้วย นอกจากนี้ เอ็นจิ้นนี้มีไว้สำหรับจัดการกับโมเดลภาษาที่มีล้านล้านพารามิเตอร์ ซึ่งเป็นงานที่ GPU ส่วนใหญ่จะพบว่าทำได้ยาก

ความก้าวหน้าทางเทคโนโลยีที่ผสมผสานกันของ NVIDIA H100 NVL อาจเร่งโมเดลภาษาขนาดใหญ่ (LLM) ได้ถึง 30 เท่าเมื่อเทียบกับรุ่นก่อนหน้า และยังทำให้เป็นผู้นำในด้าน AI การสนทนาอีกด้วย

การอนุมานโมเดลภาษาขนาดใหญ่ของ NVIDIA H100 NVL

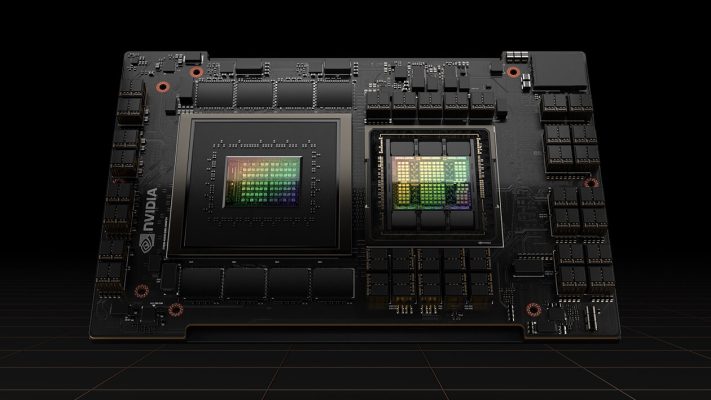

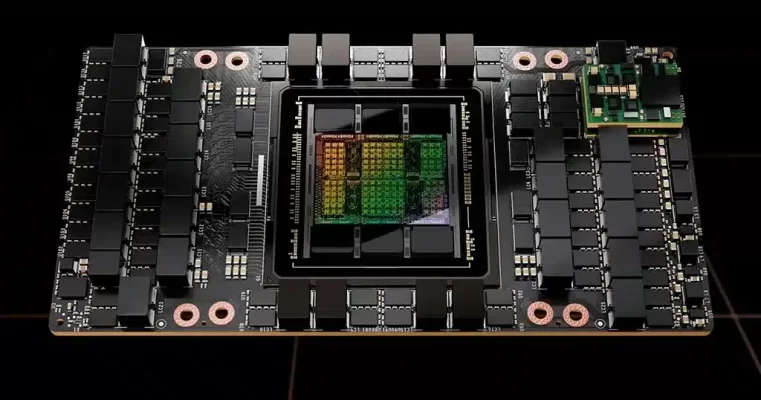

พื้นที่ NVIDIA H100 NVL ไม่ใช่แค่พลังดิบเท่านั้น มันยังเกี่ยวกับกลเม็ดเด็ดพราย NVIDIA H100 พร้อมบริดจ์ NVLink มอบประสิทธิภาพที่เหมาะสมที่สุดสำหรับ LLM ด้วยพารามิเตอร์สูงถึง 175 พันล้านพารามิเตอร์ โดยใช้ Transformer Engine, NVLink และหน่วยความจำ 188GB HBM3

นอกจากนี้ การรวมกันนี้ช่วยให้ปรับขนาดได้ง่ายในศูนย์ข้อมูลใด ๆ โดยนำ LLM เข้าสู่กระแสหลัก

เซิร์ฟเวอร์ที่ติดตั้ง NVIDIA H100 NVL GPU สามารถเพิ่มประสิทธิภาพรุ่น GPT-175B ได้สูงสุด 12 เท่าเมื่อเทียบกับระบบ NVIDIA DGX A100

การเพิ่มประสิทธิภาพนี้ทำได้ในขณะที่ยังคงความหน่วงต่ำในสถานการณ์ศูนย์ข้อมูลที่จำกัดพลังงาน ซึ่งแสดงให้เห็นถึงประสิทธิภาพของ H100 NVL

การนำ AI ระดับองค์กรมาใช้ NVIDIA H100 NVL

การนำ AI มาใช้ในองค์กรกลายเป็นกระแสหลัก และองค์กรต่างๆ ก็ต้องการโครงสร้างพื้นฐานแบบครบวงจรที่พร้อมใช้งาน AI เดอะ NVIDIA H100 NVL GPU สำหรับเซิร์ฟเวอร์หลักมาพร้อมกับการสมัครสมาชิกห้าปี รวมถึงการสนับสนุนระดับองค์กรสำหรับชุดซอฟต์แวร์ NVIDIA AI Enterprise

แพ็คเกจนี้ปรับปรุงการนำ AI ไปใช้โดยทำให้มั่นใจว่าองค์กรต่างๆ สามารถเข้าถึงเฟรมเวิร์ก AI และเทคโนโลยีที่จำเป็นสำหรับการสร้างกระบวนการ AI ที่เร่งด้วย H100 เช่น แชทบอท AI, เครื่องมือแนะนำ, AI การมองเห็น และอื่นๆ

เร่งความเร็วของปริมาณงานอย่างปลอดภัย

พื้นที่ NVIDIA H100 NVL ไม่ใช่แค่ประสิทธิภาพและความสามารถในการปรับขนาดเท่านั้น นอกจากนี้ยังเกี่ยวกับความปลอดภัย GPU มีวัตถุประสงค์เพื่อเร่งความเร็วปริมาณงานอย่างปลอดภัย ตั้งแต่ระดับองค์กรไปจนถึงขนาดเกินมาตรฐาน

มี Tensor Cores รุ่นที่ 8 และ Transformer Engine ที่มีความแม่นยำ FP4 ช่วยให้สามารถฝึกอบรมรุ่น GPT-3 (175B) ได้เร็วกว่ารุ่นก่อนหน้าถึง XNUMX เท่า

การรวมกันของ NVLink รุ่นที่ 900 ซึ่งมีการเชื่อมต่อระหว่าง GPU-to-GPU 2 GB/s; เครือข่าย NDR Quantum-5 InfiniBand ซึ่งเร่งการสื่อสารโดย GPU ทุกตัวข้ามโหนด PCIe GenXNUMX; และซอฟต์แวร์ NVIDIA Magnum IO ช่วยให้ปรับขนาดได้อย่างมีประสิทธิภาพตั้งแต่ระบบขององค์กรขนาดเล็กไปจนถึงคลัสเตอร์ GPU ขนาดใหญ่ที่รวมเป็นหนึ่งเดียว

การอนุมานการเรียนรู้เชิงลึกตามเวลาจริงของ NVIDIA H100 NVL

พื้นที่ NVIDIA H100 NVL ขยายความเป็นผู้นำด้านการอนุมานของตลาดของ NVIDIA ด้วยความก้าวหน้าหลายอย่างที่เร่งการอนุมานได้มากถึง 30 เท่า และให้เวลาแฝงที่ต่ำที่สุด

Tensor Core รุ่นที่สี่เร่งความแม่นยำทั้งหมด รวมถึง FP64, TF32, FP32, FP16, INT8 และตอนนี้ FP8 ลดการใช้หน่วยความจำและเพิ่มประสิทธิภาพในขณะที่รักษาความแม่นยำของ LLM

คอมพิวเตอร์ประสิทธิภาพสูง Exascale

พื้นที่ NVIDIA H100 NVL เพิ่มการดำเนินการทศนิยมต่อวินาที (FLOPS) ของ Tensor Cores ที่มีความแม่นยำสองเท่าถึงสามเท่า มอบการประมวลผล FP60 64 เทราฟลอปสำหรับ HPC แอปพลิเคชัน HPC ที่ผสาน AI อาจใช้ความแม่นยำ TF100 ของ H32 เพื่อให้ได้ประสิทธิภาพระดับเพตาฟล็อปสำหรับการดำเนินการคูณเมทริกซ์ความแม่นยำเดียวในขณะที่ไม่ต้องแก้ไขโค้ด

การวิเคราะห์ข้อมูลแบบเร่งความเร็วของ NVIDIA H100 NVL

พื้นที่ NVIDIA H100 NVL มอบพลังการประมวลผล—พร้อมกับแบนด์วิธหน่วยความจำ 3 เทราไบต์ต่อวินาที (TB/s) ต่อ GPU และความสามารถในการปรับขนาดด้วย NVLink และ NVSwitch—เพื่อจัดการกับการวิเคราะห์ข้อมูลด้วยประสิทธิภาพและขนาดระดับสูงเพื่อรองรับชุดข้อมูลขนาดใหญ่

สถาปัตยกรรมศูนย์ข้อมูล NVIDIA เมื่อรวมกับ NVIDIA Quantum-2 InfiniBand, ซอฟต์แวร์ Magnum IO, Spark 3.0 ที่เร่งด้วย GPU และ NVIDIA RAPIDS ได้รับการติดตั้งอย่างมีเอกลักษณ์เพื่อเร่งเวิร์กโหลดขนาดใหญ่เหล่านี้ด้วยประสิทธิภาพและประสิทธิภาพที่เหนือชั้น

การใช้งานระดับองค์กร

NVIDIA H100 NVL รวมเทคโนโลยี Multi-Instance GPU (MIG) เจนเนอเรชั่นที่สอง ซึ่งเพิ่มการใช้งาน GPU สูงสุดโดยการแบ่งอย่างปลอดภัยออกเป็นอินสแตนซ์ที่แตกต่างกันได้สูงสุดเจ็ดอินสแตนซ์

นอกจากนี้ด้วยการสนับสนุนการประมวลผลที่เป็นความลับ NVIDIA H100 NVL อนุญาตการใช้งานแบบหลายผู้เช่าที่ปลอดภัย แบบครบวงจร ทำให้เหมาะสำหรับสภาพแวดล้อมของผู้ให้บริการระบบคลาวด์ (CSP)

ระบบคอมพิวเตอร์ที่เป็นความลับในตัวด้วย NVIDIA H100 NVL

NVIDIA Confidential Computing เป็นคุณสมบัติความปลอดภัยในตัวของสถาปัตยกรรม Hopper ที่ทำให้ NVIDIA H100 NVL เครื่องเร่งความเร็วเครื่องแรกของโลกที่มีความสามารถในการประมวลผลที่เป็นความลับ

ผู้ใช้อาจรักษาความปลอดภัยและความสมบูรณ์ของข้อมูลและแอปพลิเคชันของตนในขณะที่ได้รับประโยชน์จากการเร่งความเร็วที่ไม่มีใครเทียบได้ของ H100 GPU

ประสิทธิภาพที่เหนือชั้นสำหรับ AI และ HPC ขนาดใหญ่

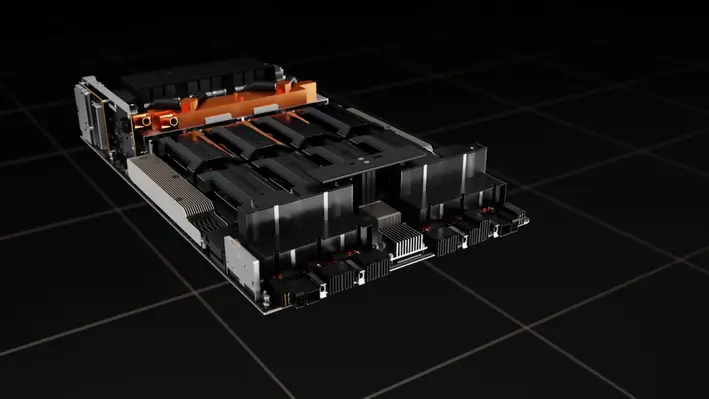

สถาปัตยกรรม NVIDIA Grace Hopper CPU+GPU ที่สร้างขึ้นโดยเฉพาะสำหรับการประมวลผลแบบเร่งความเร็วระดับเทราไบต์และเปิดใช้งานประสิทธิภาพที่สูงขึ้น 10 เท่าใน AI และ HPC รุ่นใหญ่ ก็จะใช้พลังงานจาก GPU Hopper Tensor Core

NVIDIA Grace CPU ใช้ความยืดหยุ่นของสถาปัตยกรรม Arm เพื่อสร้าง CPU และสถาปัตยกรรมเซิร์ฟเวอร์ที่ออกแบบจากล่างขึ้นบนเพื่อเร่งการประมวลผล

GPU Hopper เชื่อมต่อกับ Grace CPU ผ่านอินเทอร์เฟซแบบชิปต่อชิปความเร็วสูงพิเศษของ NVIDIA ซึ่งมีแบนด์วิดท์ 900GB/s ซึ่งเร็วกว่า PCIe Gen7 ถึง 5 เท่า

ข้อมูลจำเพาะของผลิตภัณฑ์

นี่คือตารางเปรียบเทียบของ เอช100 เอ็นวีแอล ในรูปแบบต่างๆ:

| ฟอร์มแฟกเตอร์ | FP64 | FP64 แกนเทนเซอร์ | FP32 | TF32 แกนเทนเซอร์ | BFLOAT16 แกนเทนเซอร์ | หน่วยความจำ GPU | แบนด์วิดท์หน่วยความจำ GPU |

| เอช100 เอสเอ๊กซ์เอ็ม | 34 เทราฟลอปส์ | 67 เทราฟลอปส์ | 67 เทราฟลอปส์ | 989 เทราฟลอปส์ | 1,979 เทราฟลอปส์ | 80GB | 3.35TB / s |

| H100 PCIe | 26 เทราฟลอปส์ | 51 เทราฟลอปส์ | 51 เทราฟลอปส์ | 756 เทราฟลอปส์ | 1,513 เทราฟลอปส์ | 80GB | 2TB / s |

| เอช100 เอ็นวีแอล | 68 เทราฟลอปส์ | 134 เทราฟลอปส์ | 134 เทราฟลอปส์ | 1,979 เทราฟลอปส์ | 3,958 เทราฟลอปส์ | 188GB | 7.8TB / s |

ความคิดสุดท้าย

พื้นที่ NVIDIA H100 NVL เป็นผู้เปลี่ยนเกมในโลกของการประมวลผลแบบเร่งความเร็ว ประสิทธิภาพ ความสามารถในการปรับขนาด และความปลอดภัยจะเปลี่ยนโฉม AI, HPC และการวิเคราะห์ข้อมูล การประมวลผลที่ขับเคลื่อนด้วย H100 NVL คืออนาคต

H100 NVL แสดงให้เห็นถึงความทุ่มเทของ NVIDIA ในการเร่งความเร็วการประมวลผลด้วยการอนุมานโมเดลภาษาขนาดใหญ่ที่มากเกินไป และยังให้การประมวลผลที่เป็นความลับอีกด้วย H100 NVL จะกำหนดอนาคตของคอมพิวเตอร์

วิดีโอ Youtube เกี่ยวกับ NVIDIA H100 NVL

คุณอาจจะชอบ

ประโยชน์ของ Cloud Computing สำหรับธุรกิจขนาดเล็ก

10 เกมคอมพิวเตอร์ที่ดีที่สุดตลอดกาล

คำถามที่พบบ่อย

Tensor Core GPU H100 NVL มอบประสิทธิภาพ ความสามารถในการปรับขนาด และความปลอดภัยที่ไม่มีใครเทียบได้ ระบบสวิตช์ NVLink ของ NVIDIA เชื่อมต่อ GPU H256 ได้สูงสุด 100 ตัว Transformer Engine ยังรองรับโมเดลภาษาล้านล้านพารามิเตอร์ และมีการประมวลผลแบบลับในตัว ช่วยเร่งความเร็วเวิร์กโหลดระดับองค์กรสู่ระดับ exascale

H100 NVL พร้อมสะพาน NVLink เพิ่มประสิทธิภาพ LLM ได้ถึง 175 พันล้านพารามิเตอร์โดยใช้ Transformer Engine, NVLink และหน่วยความจำ 188GB HBM3 การรวมกันนี้ทำให้ LLMs เป็นกระแสหลักโดยเปิดใช้งานความสามารถในการปรับขนาดทั่วทั้งศูนย์ข้อมูล

ซอฟต์แวร์ NVIDIA AI Enterprise ประสิทธิภาพสูงช่วยลดความยุ่งยากในการปรับใช้ AI H100 NVL GPUs สำหรับเซิร์ฟเวอร์หลักมาพร้อมกับการสมัครสมาชิกห้าปีและการสนับสนุนระดับองค์กร แพ็คเกจนี้มอบเฟรมเวิร์กและเครื่องมือกระบวนการ AI ที่เร่งด้วย H100 ให้กับองค์กรต่างๆ

เทคโนโลยี Multi-Instance GPU (MIG) รุ่นที่ 100 ของ HXNUMX NVL แบ่งพาร์ติชัน GPU แต่ละตัวออกเป็น XNUMX อินสแตนซ์อย่างปลอดภัย เพื่อเพิ่มประโยชน์สูงสุดของ GPU นอกจากนี้ยังช่วยรักษาความปลอดภัยการใช้งานแบบ end-to-end แบบหลายผู้เช่า ทำให้เหมาะสำหรับสถานการณ์ของผู้ให้บริการระบบคลาวด์ (CSP)

สถาปัตยกรรม NVIDIA Grace Hopper CPU+GPU ช่วยเร่ง AI รุ่นใหญ่และ HPC 10X สถาปัตยกรรม Arm ช่วยให้ NVIDIA Grace CPU สร้างสถาปัตยกรรม CPU และเซิร์ฟเวอร์ที่ปรับให้เหมาะสมสำหรับการคำนวณแบบเร่งความเร็ว การเชื่อมต่อชิปต่อชิปที่รวดเร็วเป็นพิเศษของ NVIDIA เชื่อมต่อ Grace CPU และ Hopper GPU ให้แบนด์วิดท์ 900GB/s ซึ่งเร็วกว่า PCIe Gen7 ถึง 5 เท่า